آنچه در این صفحه می خوانید:

معرفی یادگیری تقویتی (Reinforcement Learning)

یادگیری تقویتی (RL) بخشی از یادگیری ماشین در رشته هوش مصنوعی است که مربوط به چگونگی عملکرد نرم افزارها در یک محیط می باشد تا بتواند مفهوم پاداش تجمعی را به حداکثر برساند. یادگیری تقویتی یکی از سه الگوی اصلی یادگیری ماشین، در کنار یادگیری نظارت شده و یادگیری بدون نظارت است.

محیط به طور معمول در قالب یک فرآیند تصمیم گیری مارکوف (MDP) بیان می شود زیرا بسیاری از الگوریتم های یادگیری تقویتی کننده برای این زمینه از تکنیک های برنامه نویسی پویا استفاده می کنند. تفاوت اصلی بین روش های برنامه نویسی کلاسیک پویا و الگوریتم های یادگیری تقویتی این است که دومی دانش در مورد یک مدل دقیق ریاضی از MDP فرض نمی کند و آنها MDP های بزرگ را هدف قرار می دهند که در آن روش های دقیق غیرقابل استفاده می شوند.

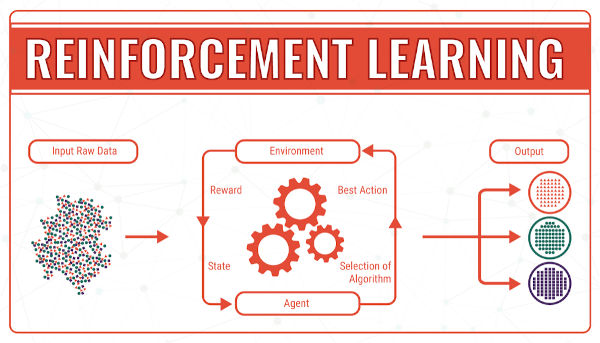

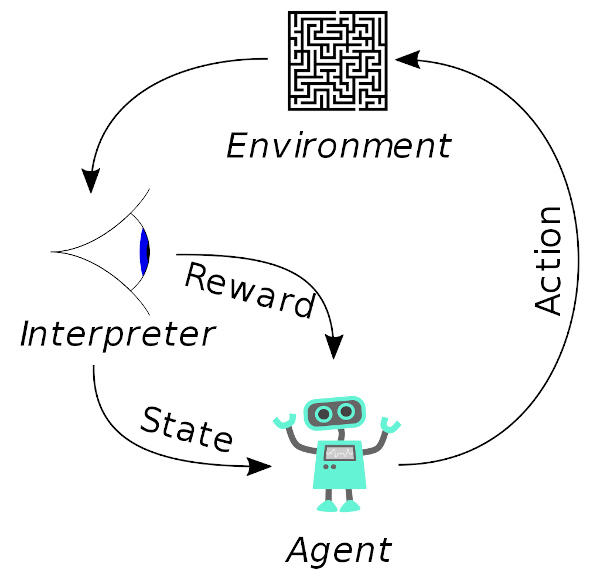

Reinforcement Learning به اختصار RL، بیش از 100 سال پیش توسط ادوارد تورندیک، روانشناس، معرفی شده بود. این تکنولوژی، به جای اینکه برنامه نویس به آنها بگوید چه کاری باید انجام دهد، اجازه می دهد که عامل کامپیوتر / نرم افزار به خودش با بهترین راه کار task را انجام دهد. تعامل بین دو عنصر محیط و عامل یادگیری قرار دارد. در این روش، عامل با محیطی که به عنوان سیگنال تقویتی شناخته می شود پاداش می گیرد. بر اساس پاداش، عامل از این دانش استفاده می کند و گزینه ها را برای اقدام بعدی می سازد. در حقیقت، رایانه ها مانند افرادی که نیاز به آموزش صریح ندارند یاد می گیرند. مجازات هایی که در طول راه برای عامل مصنوعی اتفاق می افتد، اما با روش های ثابت و محرمانه، عوامل متوجه می شوند و به بهترین روش را (بر اساس ورودی خام) بکار می گیرند.

به طور مداوم، انتخاب ها هنگام جداسازی خوب و بد انجام می شود. نمایش توسط Q-network انجام می شود که مجموع پاداش را حدس می زند. تکنولوژی در حال حاضر با ترکیبی از یادگیری عمیق قوی تر است که با استفاده از یک شبکه عصبی شبیه سازی شده برای شناسایی الگوهای / روند داده ها و انجام وظایف یادگیری کامپیوتر انجام می شود.

- مراحل "علت و معلول" برای عامل RL

- عامل مصنوعی وضعیت ورودی را تشخیص می دهد (RL ابتدا مسئله را شناسایی و فرموله می کند).

- گام بعدی توسط استراتژی معین تعیین می شود.

- سپس اقدام انجام می شود و پاداش / مجازات و مطابق با آن تقویتی می شود.

- وضعیت اعلام شده ثبت می شود.

- در نهایت، بهترین عملکرد را می توان برای افزایش نتایج تنظیم کرد.

مزایای یادگیری تقویتی

RL الگوریتم های یادگیری ماشینی است که عملکرد را به حداکثر می رساند. RL در موارد زیر به طور گسترده ای مورد استفاده قرار می گیرد:

- ساخت و تولید: ربات ها از RL در هنگام برداشتن کالاها و قرار دادن آنها در موقعیت مناسب استفاده می کنند. پس از انجام درست، روش را با دقت ادامه می دهند.

- مدیریت موجودی: استفاده از فضا امری ضروری برای تجارت الکترونیکی و خرده فروشان است - RL اجازه می دهد تا برای الگوریتم های که می تواند جهت انبارداری و بازیابی و بهبود عملیات انبار زمان را کاهش دهد.

- حسابداری: RL در ارزیابی استراتژی های معاملاتی و بهینه سازی اهداف مالی کمک می کند.

- مدیریت تحویل: RL مسائل را در Split Delivery Vehicle Routing حل می کند. Q-learning با ارائه یک وسیله نقلیه برای مشتریان متضاد مدیریت می کند.

- قیمت گذاری داینامیک: RL استراتژی ها یا بهینه سازی قیمت گذاری های پویا را از طریق تقاضا، عرضه و تعامل با مشتریان ترویج می کند.

- شخصی سازی تجارت الکترونیک: RL در تجزیه و تحلیل رفتار مصرف کننده و خرده فروشان محصولات و خدمات به عنوان منافع کمک می کند.

- صنعت پزشکی: با الگوریتم های RL به حل مشکل DTR و پردازش داده های بالینی برای تصمیم گیری بر روی یک استراتژی درمان بر اساس ورودی های بیمار می پردازند.

انواع یادگیری تقویتی

دو نوع روش یادگیری تقویتی عبارتند از:

- مثبت (Positive)

این به عنوان یک رویداد تعریف شده است، که به دلیل رفتار خاص رخ می دهد. این قدرت و فراوانی رفتار را افزایش می دهد و بر عملکردی که توسط عامل انجام می شود تأثیر مثبت می گذارد. این نوع تقویت کننده به شما کمک می کند تا حداکثر عملکرد و حفظ تغییرات را برای یک دوره طولانی تر انجام دهید. با این حال، تقویت بیش از حد ممکن است به بهینه سازی بیش از حد حالت منجر شود، که می تواند نتایج را تحت تأثیر قرار دهد.

- منفی (Negative)

تقویت منفی به عنوان تقویت رفتارهایی تعریف می شود که به دلیل شرایط منفی که باید متوقف شده یا از آن جلوگیری می شود، رخ می دهد. این به شما کمک می کند حداقل موضع عملکرد را تعیین کنید.